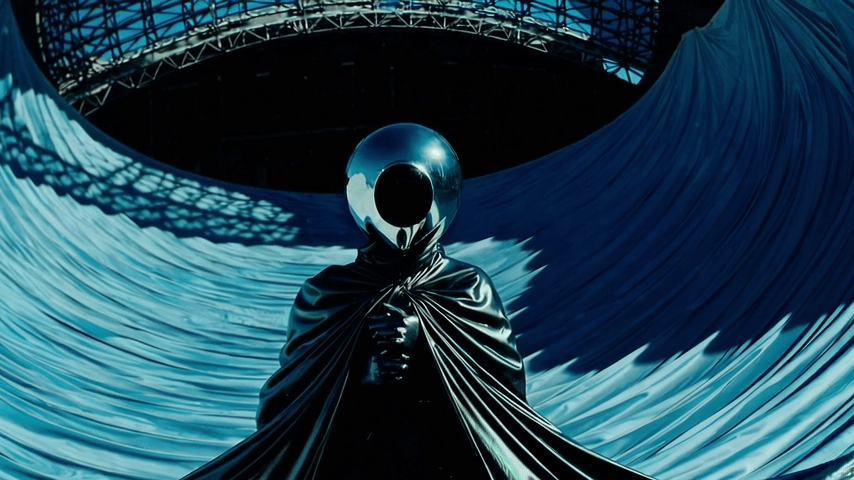

Akasha, alias di Riccardo Franco-Loiri, è un visual artist e performer che sviluppa la sua ricerca nell’astrattismo digitale, esplorando le estetiche post-internet e l’arte generativa attraverso le potenzialità dell’intelligenza artificiale e del codice, approfondendo il rapporto tra percezione e rappresentazione. I suoi lavori spaziano dal videomapping architetturale alle performance immersive e installazioni audiovisive. Nel 2018 ha co-fondato lo studio High Files, specializzato in visual design per show musicali e teatrali, videomapping ed esperienze immersive. Tra gli ultimi progetti ci sono i visuals dei tour di concerti di Lazza, Subsonica, Capo Plaza e Angelina Mango.

Sempre con High Files, nel 2024 inaugura la loro prima mostra immersiva personale, Into the Mind of AI, presso theLeonardo di Salt Lake City, che approda a gennaio 2025 alla W1 Gallery di Londra.Parallelamente, si dedica alla direzione e produzione di videoclip musicali.

Dal 2023 collabora con Gabriele Ottino di SPIME.IM nella creazione di videoclip musicali utilizzando tecniche di AI sperimentali. Insieme hanno diretto Hint (Spime.IM + Akasha), Universo (Subsonica) e l’ultimo videoclip di LIBERATO, Turnà.

Le sue opere e interviste sono state pubblicate su Fact.mag, Stir, Domus, Clot, XLR8R, e ha presentato le sue performance e installazioni in festival di rilievo internazionale, tra cui Mutek Japan, AIFF Venice Film Festival, Nextones, Bright Leipzig, Seeyousound, Constellation de Metz e Blaues Rauschen.

SM: Il tuo lavoro si muove tra glitch art, estetiche post-internet e motion design. Come si è evoluto il tuo linguaggio visivo nel tempo e quali influenze hanno segnato maggiormente il tuo percorso?

A:

La prima volta che capii cosa volevo fare davvero nel mio futuro fu durante un’“ora buca”.

Ero al liceo, in terza, e un professore era assente. La professoressa di Arte venne a

sostituirlo, accese il piccolo proiettore che avevamo in classe e mise su un video per

tenerci buoni. Disse che le era piaciuto molto: si trattava di un lavoro prodotto durante il

Kernel Festival, un festival di arte digitale organizzato a Villa Reale, Monza. Mostrava la

facciata della villa animarsi, distruggersi e rigirarsi su sé stessa, bombardata da flash

luminosi e grafiche digitali. Fu la prima volta che vidi un videomapping e ne rimasi

folgorato. Mi segnai il nome e iniziai a fare ricerche su internet. Quel “videomapping”

sembrava essere esattamente ciò che volevo fare “da grande”: un’unione perfetta tra

musica, cinema, grafica e arte, con una forte impronta creativa e non meramente tecnica.

Una sorta di opera d’arte totale, ma anche un insieme di calibrati trucchi illusionistici.

Un paio d’anni dopo, appena diplomato, quando mi ritrovai a scegliere cosa fare della mia

vita, non avevo dubbi. Tuttavia, il videomapping non veniva insegnato da nessuna parte.

Nello stesso periodo, un amico più grande di me, grafico, mi mostrò un’immagine molto

potente: raffigurava la Luna, ma era come spaccata a metà. Un errore digitale rompeva

l’immagine e dissipava la texture tra linee e gradienti sbagliati, simile a quando il digitale

terrestre (nome ancora oggi incredibile, ndr) perdeva il segnale. Rimasi ipnotizzato.

L’immagine era stata ottenuta corrompendo il file, e il mio amico la chiamava glitch.

Grazie a qualche suo consiglio, entrai in contatto con la comunità internazionale della

Glitch Art ed è stato come cadere nella tana del Bianconiglio.

Da quel momento, il mondo dell’illusionismo digitale e quello effimero della glitch art

divennero i capisaldi della mia ricerca. La possibilità di rompere un’immagine per

generarne una nuova, di creare illusioni ottiche su larga scala con tecnologia accessibile,

divenne il mezzo con cui esprimere le tante istanze artistiche che sentivo dentro.

A:

Sono sempre stato affascinato dall’astrattismo e dal calcolo. Arte e scienza sono sempre

state i miei strumenti per indagare il mondo, filtrandolo attraverso la mia visione più intima

e spirituale. Il mio lavoro si è sempre basato sulla creazione di parallelismi tra il reale e il

digitale, elaborando nuove idee e speculazioni.

Negli anni, ho ampliato le mie tecniche, approfondendo l’arte algoritmica e generativa,

sperimentando con fotogrammetria, scansione 3D, realtà virtuale e aumentata. Poi è

arrivato il punto di svolta.

Nel marzo 2021, scoprii un nuovo modello di AI chiamato Disco Diffusion.

Era qualcosa di mai visto: un modello che genera immagini partendo dal rumore casuale,

raffinando progressivamente i dettagli, come se “togliendo la nebbia” rivelasse

un’immagine sottostante.

Fino a quel momento avevo sperimentato con GAN (Generative Adversarial Networks), ma

i risultati erano più limitati. Disco Diffusion era incredibilmente più veloce ed efficace.

Da lì, i modelli di diffusione sono diventati strumenti centrali nel mio lavoro.

L’AI generativa sta rivoluzionando il mondo visivo come il digital processing e la sintesi

sonora hanno trasformato il mondo musicale: un’ondata di creatività ha travolto il

panorama artistico, con nuove scoperte quotidiane.

Questo iper-accelerazionismo coincide perfettamente con l’epoca attuale: la crescita

dell’AI nel campo visuale procede di pari passo con quella nei Large Language Models

(LLM) come ChatGPT, sviluppati nello stesso periodo.

Negli ultimi anni, l’AI ha amplificato le mie capacità creative e mi ha permesso di

partecipare a progetti importanti. Tuttavia, rimango critico nei confronti del suo impatto, in

particolare sul rischio di monopolizzazione da parte delle big tech.

L’AI open-source è essenziale. Stable Diffusion è un esempio virtuoso: un modello globale,

nato libero e accessibile, che spero possa contrastare i sistemi chiusi delle grandi aziende.

SM: Nel videoclip Turnà di Liberato hai sperimentato con Sora, anticipando l’uso dell’AI video generation nella produzione musicale italiana. Come è nata questa collaborazione e quali sfide hai affrontato?

A:

La nostra collaborazione è iniziata con un messaggio di Francesco Lettieri, regista e figura chiave dietro tutta l’estetica e i video di LIBERATO.

Francesco era stato in giuria per un concorso di videoclip musicali e aveva visto “Hint”, un

lavoro del 2023 nato dalla mia collaborazione con Gabriele Ottino e SPIME.IM, collettivo

audiovisivo composto da amici e colleghi torinesi. “Hint” è un video che fonde riprese reali,

animazione 3D e trattamento AI con un approccio volutamente isterico e destrutturante.

Era in perfetta sintonia con la mia idea di glitch art, un’indagine visiva che esplorava il divario sociale e le sue possibili evoluzioni future.

Dopo aver visto il video, Francesco ci contattò: voleva affidarci la produzione del nuovo videoclip di LIBERATO, che avrebbe segnato il suo ritorno sulla scena dopo l’ultimo album.

L’idea era chiara: un video che mescolasse ripresa reale e manipolazione artificiale.

A:

Coincidenza (o destino?), proprio nei giorni in cui Francesco ci formalizzò la richiesta, Gabriele era stato appena invitato da una nostra collega e amica (@niceaunties, ndr) a partecipare come uno dei 300 artisti nell’alpha-testing di Sora, il nuovo modello di sintesi

video sviluppato da OpenAI. Gabriele, a sua volta, invitò me. Dopo un breve colloquio, venni

introdotto anch’io nel programma. Tutto questo accadeva mentre ci trovavamo entrambi a Tokyo, ospiti di Mutek Festival, dove stavamo presentando una versione estesa di Hint come video installazione. L’intera situazione mi sembrava surreale, quasi più causale che casuale.

Proponemmo subito a Francesco di sperimentare Sora per il nuovo videoclip di LIBERATO, anche se il software era ancora in fase di pre-rilascio e non esistevano linee guida chiare su come presentare lavori creati con quel modello. Dopo un confronto diretto con il team di OpenAI, ottenemmo l’autorizzazione a pubblicarlo non appena fosse stato pronto.

A quel punto, ci siamo lanciati in questo territorio inesplorato. Abbiamo coordinato un

team per le riprese a Napoli, con il supporto diretto di Francesco e Liberato, per produrre il

materiale grezzo su cui poi avremmo applicato le elaborazioni con Sora. Il risultato finale

ci ha sorpresi. Alcune delle scelte visive più interessanti sono nate dagli errori, dalle catene di reprocessing che a volte generavano immagini e transizioni totalmente impreviste. Nel continuo scambio tra AI, realtà e post-produzione, abbiamo trovato la cifra stilistica del video, mantenendo un tono ironico e surreale.

A:

L’intero processo è stato un vero laboratorio sperimentale. Ogni giorno veniva rilasciato un

aggiornamento su Sora, e noi testavamo nuove funzionalità, confrontandoci con gli altri

pochi utenti della piattaforma. Ci siamo scontrati con intoppi, ridefinizioni e continui

adattamenti, ma alla fine siamo rimasti pienamente soddisfatti del risultato.

A mezzanotte del 1° gennaio 2025, il videoclip di “Turnà” è uscito. E con lui si è aperto un

anno che – si spera – sarà colmo di nuove sperimentazioni.

SM: Into the Mind of AI porta il pubblico dentro una visione artificiale, trasformando il processo creativo in un dialogo tra umano e macchina. C’è stato un momento in cui l’output dell’AI ti ha sorpreso o portato il progetto in una direzione inaspettata?

A:

Uno degli aspetti più affascinanti nel lavorare con modelli di AI è proprio la loro

imprevedibilità. Fin dai miei primi esperimenti, ho sempre cercato di ibridare soggetti e

ambienti in modo organico e surreale, mantenendo una sorta di realismo di fondo. Alcuni

dei risultati più impressionanti sono nati portando certi processi all’estremo, altri da una

parola casualmente cambiata in un prompt.

Quello che succede nella black box dell’AI ha un che di alchemico. Generare un’animazione diventa un’abile miscela di parametri, come fossero ingredienti di una pozione.

Per Into the Mind of AI, io e il mio socio Tommaso Rinaldi abbiamo passato lunghe notti a

testare nuovi workflow, esplorando metodi per fondere tecniche di 3D, generazione real-time e AI-generated visuals. Dalla strutturazione del concept alla consegna finale, abbiamo cercato di associare ogni capitolo dell’opera a un preciso utilizzo dell’AI. In alcuni casi, la sintesi AI veniva utilizzata per generare immagini e animazioni; in altri, serviva a

determinare parametri variabili a partire da dataset; altre volte ancora, veniva utilizzata per

interpolare video reali con contenuti artificiali o per analizzare le stesse immagini generate e rielaborarle in tempo reale.

Nella parte finale dell’opera, ipotizziamo due scenari per un mondo sovraccarico di

artificiale: uno distopico e uno utopico. Anche in questo caso, abbiamo interrogato modelli

GPT per costruire un dialogo su come potrebbero svilupparsi futuri estremi in cui l’AI si

espande a livello globale. Ti confesso che alcuni scenari catastrofici proposti dall’AI

sembrano oggi tremendamente realistici.

A:

È passato solo un anno da quando abbiamo inaugurato Into the Mind of AI al theLeonardo

di Salt Lake City, e già tutto è cambiato a una velocità allucinante. Quando, dodici mesi dopo, abbiamo aggiornato la mostra per W1 Gallery, Londra, ci siamo resi conto di quanto il mondo dell’AI generativa fosse già mutato.

L’iper-accelerazionismo legato a queste tecnologie è stupefacente. Modelli nuovi e

sempre più potenti emergono a ritmi impensabili, superando limiti che fino a poco fa

sembravano invalicabili. Mi domando quanto potremo ancora reggere questo ritmo. E

soprattutto, quando inizieremo a renderlo più sostenibile.

L’AI è una scoperta incredibile. Ma, come tutte le scoperte rivoluzionarie, può anche fare

molto male. Ogni volta che una nuova tecnologia emerge, il mio entusiasmo è accompagnato da un piccolo avviso nella mente: questa corsa può portarci lontano, ma è essenziale scegliere bene la direzione.